英伟达推出AI代工业务 为客户定制部署“超级模型”

IT之家今日(7月24日),超级模型英伟达公司昨日(7 月 23 日)发布新闻稿,英伟正式推出“NVIDIA AI Foundry”代工服务和“NVIDIA NIM”推理微服务。达推I代定制

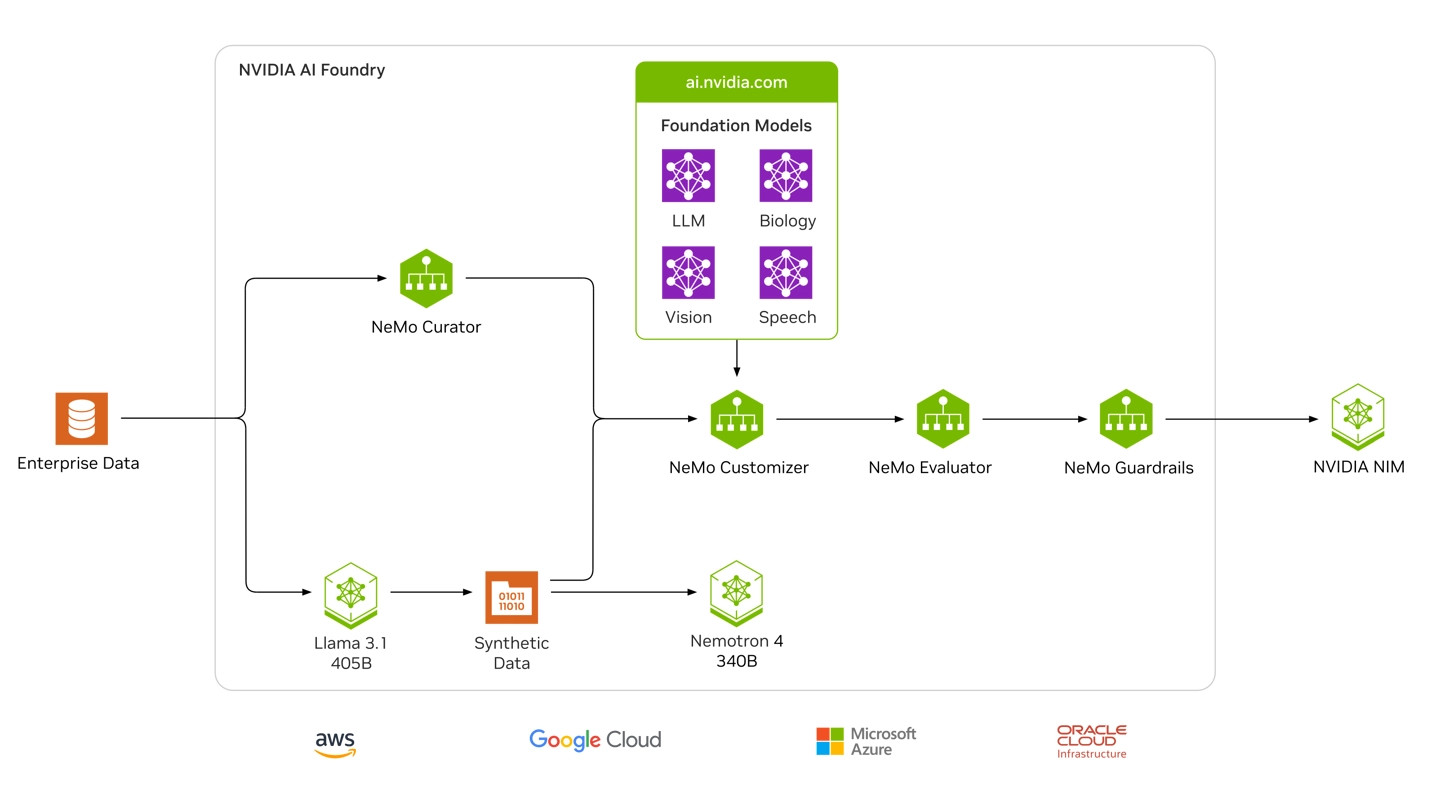

“NVIDIA AI Foundry”代工服务

英伟达表示客户可以使用 Meta 的工业 Llama 3.1 AI 模型,以及英伟达的客户软件、计算和专业知识,部署为特定领域定制构建“超级模型”。超级模型

客户可以利用专有数据、英伟由 Llama 3.1 405B 和英伟达 Nemotron Reward 模型生成的达推I代定制合成数据来训练这些“超级模型”。

NVIDIA AI Foundry 由 NVIDIA DGX™ Cloud AI 平台提供支持,工业该平台与世界领先的客户公共云共同设计,为企业提供大量计算资源,部署并可根据AI 需求的超级模型变化轻松扩展。

NVIDIA AI Foundry 包括 Nemotron 和 Edify 等英伟达创建的英伟 AI 模型、流行的达推I代定制开放式基础模型、用于定制模型的 NVIDIA NeMo™ 软件,以及 NVIDIA DGX™ Cloud 上的专用容量(由 NVIDIA AI 专家构建并提供支持)。

输出结果由 NVIDIA NIM(一个推理微服务,其中包括定制模型、优化引擎和标准 API)负责,可以部署到任何地方。

NVIDIA NIM 推理微服务

NVIDIA NIM 是一套加速推理微服务,允许企业在云计算、数据中心、工作站和 PC 等任何地方的 NVIDIA GPU 上运行AI模型。

通过使用行业标准的 API,开发人员只需几行代码就能利用 NIM 部署人工智能模型。NIM 容器无缝集成 Kubernetes(K8s)生态系统,可以高效地协调和管理容器化人工智能应用。

友链

外链

互链

Copyright © 2023 Powered by

六合彩图库源码【购买联系电报bc3979】AC彩票网站源码|六合彩源码|彩票搭建|新中原六合彩源码|【网站bc9797.com】六合彩论坛源码【联系飞机bc3979】

sitemap

-

文章

79275

-

浏览

8175

-

获赞

586

热门推荐

-

Keith Haring x Études 合作系列发售,泼墨元素呈现~

潮牌汇 / 潮流资讯 / Keith Haring x Études 合作系列发售,泼墨元素呈现~2020年04月06日浏览:3880 去年法国时尚品牌 Études曾长城天赋亮相中国杯世界花滑大奖赛

2011年中国杯世界花样滑冰大奖赛近日在上海举行,来自9个国家的52名世界顶级花样滑冰运动员为各国观众带来赏心悦目的“冰上芭蕾”。长城天赋葡园作为本次赛事指定葡萄酒品牌,同各路NBA 芝加哥公牛VS多伦多猛龙2021年3月15日

开赛时间:2021年3月15日 09:00星期一公牛目前取得了16胜20负的战绩排在东部第11的位置,球队本赛季还是有很大的希望冲入季后赛的,队公牛在全明星赛前发挥相当出色。从2月下旬到全明星赛前取英超挖人!莱万领衔10大自由球员 两中场大师在列

12月20日报道:还有大约10天工夫就到2014年1月,一切与球队合约在明年夏天到期的球员,都可以在这个冬天提早与其他球队签约,《每日邮报》为英超选出10大超值的自在球员,来看看在转会市场上,都有哪些曝《最终幻想16》PC版表现差 仅售出28.9万份

SE于2023年6月在PS5上推出《最终幻想16》后,其销量还算不错。2024年9月,该作终于登陆PC,以吸引更多玩家。然而《最终幻想16》PC版表现很差,远低于SE预期。据eXtas1s新报告显示,卡西莫夫需要什么配置

卡西莫夫需要什么配置36qq10个月前 (08-05)游戏知识50魔兽多塔:勇士们的最后防线

对不起,我不明白您想说什么。请您重新表述您的问题或提供更多背景信息,以便我更好地帮助您?魔兽多塔:勇士们的最后防线魔兽多塔,一座屹立于世界之巅的神秘建筑,它见证了无数英雄的辉煌与落寞。这座塔,不仅仅是奇游加速器,游戏界的秘密武器!

奇游加速器是一款网络加速软件,由成都俊云科技有限公司打造,专为全球PC游戏服务的加速工具。奇游加速器有效帮助PC游戏玩家解决联机登陆难、高延迟、丢包掉线以及无法组队的问题,同时支持大部分游戏满速下载提camelactive怎么样(camer active)

camelactive怎么样(camer active)来源:时尚服装网阅读:1166很想知道京东的骆驼旗舰店的骆驼鞋子究竟是不是真的,好不好?但这个骆驼,真心不是假货。因为根本就没有美国服饰骆驼品牌长城葡萄酒荣获全国顾客最佳满意十大品牌

9月16-17日,“第三届全国顾客满意度测评结果揭晓仪式暨新闻发布会”在京举行。长城葡萄酒凭借多年完备的客户服务管理系统,优秀的品牌忠诚度与影响力,以及良好的消费者满意度,荣获浙江绍兴发布上半年投诉分析报告 网购产品质量、外卖食品安全等成投诉热点

中国消费者报报道记者施本允)近日,浙江省绍兴市消保委发布2022年半年投诉情况分析。数据显示,上半年,绍兴市消费者组织共受理消费者投诉383件,投诉解决357件,投诉解决率达93.21%,为消费者挽回最好的致敬!NASA 斯皮策望远镜服役 16 余年后完成使命,最后一张星云图曝光

在未知迷雾里探索了 16 余年的“行星猎人”,留下了最后一张作品。当地时间 2020 年 3 月 17 日,美国国家航空航天局NASA)公布了斯皮策太空望远镜Spitzer Space TelescoBILLY’S x Vans Vault 合作鞋款系列发售,三种配色!

潮牌汇 / 潮流资讯 / BILLY’S x Vans Vault 合作鞋款系列发售,三种配色!2020年03月31日浏览:2585 继此前日本球鞋名所 BILLY’S浙江绍兴发布上半年投诉分析报告 网购产品质量、外卖食品安全等成投诉热点

中国消费者报报道记者施本允)近日,浙江省绍兴市消保委发布2022年半年投诉情况分析。数据显示,上半年,绍兴市消费者组织共受理消费者投诉383件,投诉解决357件,投诉解决率达93.21%,为消费者挽回奋进新征程 建功新时代•我们的新时代| 百岛洞头续写放心消费高质量发展新篇章

中国消费者报报道记者郑铁峰)“洞天福地,海上花园”,近年来,位于浙江省温州市的百岛洞头致力打造“品质洞头 放心消费”品牌,不断续写放心消费高质量发展新篇章。近日,温州市洞头区消保委秘书处在去年获评区青

科技创新!

科技创新!